Neuromorphes Computing

Was ist neuromorphes Computing?

Neuromorphes Computing (Neuromorphic Computing) oder neuromorphe Datenverarbeitung ist eine Methode der Computertechnik, bei der Elemente eines Computers nach dem Vorbild von Systemen im menschlichen Gehirn und Nervensystem modelliert werden. Der Begriff bezieht sich auf das Design von Hardware- und Software-Computing-Elementen. Neuromorphe Datenverarbeitung wird manchmal auch als neuromorphes Engineering bezeichnet.

Neuromorphe Entwickler und Ingenieure bedienen sich verschiedener Disziplinen – darunter Informatik, Biologie, Mathematik, Elektrotechnik und Physik –, um bioinspirierte Computersysteme und Hardware zu entwickeln. Von den biologischen Strukturen des Gehirns werden neuromorphe Architekturen am häufigsten nach Neuronen und Synapsen modelliert. Dies liegt daran, dass Neurowissenschaftler Neuronen als die grundlegenden Einheiten des Gehirns betrachten.

Neuronen verwenden chemische und elektronische Impulse, um Informationen zwischen verschiedenen Regionen des Gehirns und dem Rest des Nervensystems zu senden. Neuronen verwenden Synapsen, um sich miteinander zu verbinden. Neuronen und Synapsen sind weitaus vielseitigere, anpassungsfähigere und energieeffizientere Informationsprozessoren als herkömmliche Computersysteme.

Neuromorphe Datenverarbeitung ist ein aufstrebendes Wissenschaftsfeld, für das es noch keine realen Anwendungen gibt. Verschiedene Gruppen, darunter Universitäten, Militär und Technologieunternehmen wie Intel Labs und IBM, führen derzeit Forschungen durch.

Die neuromorphe Technologie wird voraussichtlich in folgenden Anwendungsfällen eingesetzt:

- Deep-Learning-Anwendungen

- Halbleiter der nächsten Generation

- Transistoren

- Accelerator

- autonome Systeme wie Roboter, Drohnen, selbstfahrende Autos und künstliche Intelligenz (KI)

Einige Experten sagen voraus, dass neuromorphe Prozessoren einen Weg bieten könnten, die Grenzen des Mooreschen Gesetzes zu umgehen.

Die Bemühungen, künstliche allgemeine Intelligenz (Artificial General Intelligence, AGI) zu erzeugen, treiben auch die neuromorphe Forschung voran. AGI bezieht sich auf einen KI-Computer, der wie ein Mensch versteht und lernt. Durch die Nachbildung des menschlichen Gehirns und Nervensystems kann AGI theoretisch ein künstliches Gehirn mit den gleichen kognitiven Fähigkeiten wie ein biologisches Gehirn erzeugen. Ein solches Gehirn kann Erkenntnisse über die Kognition liefern und Fragen zum Bewusstsein beantworten.

Wie funktioniert neuromorphes Computing?

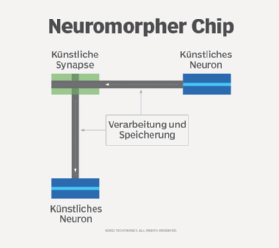

Neuromorphes Computing verwendet Hardware, die auf den Strukturen, Prozessen und Kapazitäten von Neuronen und Synapsen in biologischen Gehirnen basiert. Die häufigste Form neuromorpher Hardware sind gepulste neuronale Netze (Spiking Neural Network, SNN). In dieser Hardware verarbeiten und speichern Knoten – oder Spiking Neurons – Daten wie biologische Neuronen.

Künstliche synaptische Vorrichtungen verbinden die Neuronen. Diese Vorrichtungen verwenden analoge Schaltkreise, um elektrische Signale zu übertragen, die Gehirnsignale imitieren. Anstatt Daten wie die meisten Standardcomputer über ein binäres System zu kodieren, messen und kodieren gepulste Neuronen die diskreten analogen Signaländerungen selbst.

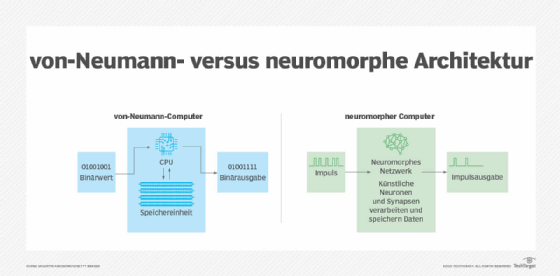

Die in neuromorphen Computern verwendete Hochleistungsrechnerarchitektur und -funktionalität unterscheidet sich von der Standard-Computerhardware der meisten modernen Computer, die auch als von-Neumann-Rechner bekannt sind.

von-Neumann-Computer

von-Neumann-Computer weisen folgende Merkmale auf:

- Getrennte Verarbeitungs- und Speichereinheiten. Von-Neumann-Computer verfügen über separate Prozessoren zur Datenverarbeitung und Speichereinheiten zur Datenspeicherung.

- Binärwerte. Von-Neumann-Computer codieren Daten mithilfe von Binärwerten.

- Geschwindigkeits- und Energieprobleme. Um Daten zu berechnen, müssen diese zwischen den separaten Verarbeitungs- und Speicherorten verschoben werden. Dieser Ansatz wird als von-Neumann-Flaschenhals bezeichnet. Er begrenzt die Geschwindigkeit eines Computers und erhöht seinen Energieverbrauch. Neuronale Netze und maschinelle Lernsoftware, die auf von-Neumann-Hardware ausgeführt werden, müssen in der Regel entweder eine schnelle Berechnung oder einen niedrigen Energieverbrauch bieten, wobei das eine auf Kosten des anderen geht.

Neuromorphe Computer

Neuromorphe Computer weisen folgende Merkmale auf:

- Kollokation von Verarbeitung und Speicher. Die vom Gehirn inspirierten neuromorphen Computerchips verarbeiten und speichern Daten gemeinsam auf jedem einzelnen Neuron, anstatt für jedes Neuron einen separaten Bereich zu haben. Durch die Kollokation von Verarbeitung und Speicher vermeiden neuronale Netzprozessoren und andere neuromorphe Prozessoren den von-Neumann-Engpass und können gleichzeitig sowohl eine hohe Leistung als auch einen niedrigen Energieverbrauch aufweisen.

- Massiv parallel. Neuromorphe Chips wie der Loihi 2 von Intel Labs können bis zu eine Million Neuronen haben. Jedes Neuron arbeitet gleichzeitig an verschiedenen Funktionen. Theoretisch können neuromorphe Computer so viele Funktionen gleichzeitig ausführen, wie es Neuronen gibt. Diese Art der parallelen Funktionsweise ahmt stochastisches Rauschen nach, das heißt die scheinbar zufälligen Entladungen von Neuronen im Gehirn. Neuromorphe Computer sind so konzipiert, dass sie dieses stochastische Rauschen besser verarbeiten können als herkömmliche Computer.

- Inhärent skalierbar. Neuromorphe Computer haben keine traditionellen Hindernisse für die Skalierbarkeit. Um größere Netzwerke zu betreiben, fügen Benutzer mehr neuromorphe Chips hinzu, wodurch sich die Anzahl der aktiven Neuronen erhöht.

- Ereignisgesteuerte Berechnung. Einzelne Neuronen und Synapsen rechnen als Reaktion auf Impulse von anderen Neuronen. Das bedeutet, dass nur der kleine Teil der Neuronen, die tatsächlich Impulse verarbeiten, Energie verbrauchen; der Rest des Computers bleibt im Leerlauf. Dies sorgt für eine äußerst effiziente Energienutzung.

- Hohe Anpassungsfähigkeit und Plastizität. Wie Menschen sind neuromorphe Computer so konzipiert, dass sie flexibel auf sich ändernde Reize aus der Außenwelt reagieren können. In der Architektur gepulster neuronaler Netze wird jeder Synapse ein Spannungsausgang zugewiesen, der diesen Ausgang je nach Aufgabe anpasst. SNNs sind so konzipiert, dass sie als Reaktion auf potenzielle synaptische Verzögerungen und die Spannungsschwelle eines Neurons unterschiedliche Verbindungen entwickeln. Durch die erhöhte Plastizität erhoffen sich die Forscher, dass neuromorphe Computer lernen, neuartige Probleme lösen und sich schnell an neue Umgebungen anpassen können.

- Fehlertoleranz. Neuromorphe Computer sind äußerst fehlertolerant. Wie im menschlichen Gehirn werden Informationen an mehreren Stellen gespeichert, sodass der Ausfall einer Komponente die Funktionsfähigkeit des Computers nicht beeinträchtigt.

Herausforderungen beim neuromorphen Computing

Viele Experten sind der Meinung, dass neuromorphes Computing das Potenzial hat, die algorithmische Leistung, Effizienz und Fähigkeiten der KI zu revolutionieren und Erkenntnisse über die Kognition zu gewinnen. Allerdings befindet sich das neuromorphe Computing noch in einem frühen Entwicklungsstadium und steht vor mehreren Herausforderungen:

- Genauigkeit. Neuromorphe Computer sind energieeffizienter als neuronale Hardware für Deep Learning und maschinelles Lernen sowie Edge-Grafikprozessoren (GPUs). Sie haben sich jedoch noch nicht als eindeutig genauer erwiesen. In Kombination mit den hohen Kosten und der Komplexität der Technologie führt das Genauigkeitsproblem dazu, dass viele traditionelle Software bevorzugen.

- Begrenzte Software und Algorithmen. Die Software für neuromorphes Computing hat nicht mit der Hardware Schritt gehalten. Der Großteil der neuromorphen Forschung wird immer noch mit Standard-Deep-Learning-Software und Algorithmen durchgeführt, die für von-Neumann-Hardware entwickelt wurden. Dies beschränkt die Forschungsergebnisse auf Standardansätze, über die das neuromorphe Computing hinausgehen will. Katie Schuman, eine Forscherin im Bereich neuromorpher Computer und Assistenzprofessorin an der University of Tennessee, sagte in einem Interview mit Ubiquity, dass die Einführung neuromorpher Computertechnologien „einen Paradigmenwechsel in der Art und Weise erfordern wird, wie wir über Computer als Ganzes denken ... Obwohl dies eine schwierige Aufgabe ist, hängt die weitere Innovation im Bereich der Computer von unserer Bereitschaft ab, über unsere traditionellen von-Neumann-Systeme hinauszugehen.“

- Unzugänglich. Neuromorphe Computer sind für Laien nicht verfügbar. Softwareentwickler haben noch keine Programmierschnittstellen, Programmiermodelle und -sprachen entwickelt, um neuromorphe Computer breiter verfügbar zu machen.

- Benchmarks. In der neuromorphen Forschung fehlen klar definierte Benchmarks für Leistung und gängige Problemstellungen. Ohne diese Standards ist es schwierig, die Leistung neuromorpher Computer zu bewerten und ihre Wirksamkeit nachzuweisen.

- Neurowissenschaften. Neuromorphe Computer sind auf die bekannten Strukturen der menschlichen Kognition beschränkt, die noch lange nicht vollständig verstanden ist. So gibt es beispielsweise mehrere Theorien, die besagen, dass die menschliche Kognition auf Quantenberechnungen basiert, wie die von Sir Roger Penrose und Stuart Hameroff vorgeschlagene Orch-Theorie (OR). Wenn die Kognition Quantenberechnungen im Gegensatz zu Standardberechnungen erfordert, wären neuromorphe Computer unvollständige Annäherungen an das menschliche Gehirn und müssten möglicherweise Technologien aus Bereichen wie dem Wahrscheinlichkeits- und Quantencomputing integrieren.

Was sind die Anwendungsfälle für neuromorphes Computing?

Trotz der Herausforderungen ist neuromorphes Computing nach wie vor ein hochfinanziertes Feld. Experten sagen voraus, dass neuromorphe Computer aufgrund ihrer geringeren Größe und ihres niedrigen Stromverbrauchs für die Ausführung von KI-Algorithmen am Netzwerkrand statt in der Cloud eingesetzt werden. Ähnlich wie ein Mensch wäre eine KI-Infrastruktur, die auf neuromorpher Hardware läuft, in der Lage, sich an ihre Umgebung anzupassen, sich an das Notwendige zu erinnern und bei Bedarf auf externe Quellen wie die Cloud zuzugreifen, um weitere Informationen zu erhalten.

Zu den weiteren potenziellen Anwendungen dieser Technologie gehören:

- autonome Fahrzeuge

- Drohnen

- Roboter

- Smart-Home-Geräte

- Verarbeitung natürlicher Sprache, Sprache und Bilder

- Datenanalyse

- Prozessoptimierung

Die Forschung im Bereich des neuromorphen Rechnens verfolgt in der Regel entweder einen rechnerischen Ansatz, der sich auf eine verbesserte Effizienz und Verarbeitung konzentriert, oder einen neurowissenschaftlichen Ansatz, um mehr über das menschliche Gehirn zu erfahren. Beide Ansätze generieren Wissen, das für die Weiterentwicklung der KI erforderlich ist.

Beispiele für den rechnerischen Ansatz

- Loihi 2 von Intel Lab verfügt über zwei Millionen Synapsen und über eine Million Neuronen pro Chip. Sie sind für SNNs optimiert.

- Der Pohoiki-Beach-Computer von Intel Lab verfügt über 8,3 Millionen Neuronen. Er bietet eine 1.000-mal bessere Leistung und eine 10.000-mal höhere Effizienz als vergleichbare GPUs.

- Der TrueNorth-Chip von IBM verfügt über mehr als 1 Million Neuronen und über 256 Millionen Synapsen. Er ist 10.000-mal energieeffizienter als herkömmliche Mikroprozessoren und verbraucht nur dann Strom, wenn er benötigt wird.

- NeuRRAM ist ein neuromorpher Chip, der KI-Systeme unabhängig von der Cloud laufen lässt.

Beispiele für den neurowissenschaftlichen Ansatz

- Der Tianjic-Chip, der von chinesischen Wissenschaftlern entwickelt wurde, wird zur Stromversorgung eines selbstfahrenden Fahrrads verwendet, das einer Person folgen, Hindernisse umfahren und auf Sprachbefehle reagieren kann. Er verfügt über 40.000 Neuronen und 10 Millionen Synapsen und ist 160-mal leistungsfähiger und 120.000-mal effizienter als eine vergleichbare GPU.

- Das Human Brain Project (HBP) ist ein Forschungsprojekt, das vom Neurowissenschaftler Henry Markram mit finanzieller Unterstützung der Europäischen Union ins Leben gerufen wurde und versucht, ein menschliches Gehirn zu schaffen. Es verwendet zwei neuromorphe Supercomputer, SpiNNaker und BrainScaleS, die von verschiedenen Universitäten gemeinsam entwickelt wurden. Mehr als 140 Universitäten in ganz Europa arbeiten an dem Projekt.

- BrainScaleS wurde von der Universität Heidelberg in Zusammenarbeit mit anderen Universitäten entwickelt. Es verwendet neuromorphe Hybridsysteme, die biologische Experimente mit rechnergestützten Analysen kombinieren, um die Informationsverarbeitung im Gehirn zu untersuchen.

Neuromorphe Datenverarbeitung und künstliche allgemeine Intelligenz

Künstliche allgemeine Intelligenz (Artificial General Intelligence, AGI) bezieht sich auf KI, die eine dem Menschen gleichwertige Intelligenz aufweist. Das Erreichen von AGI ist das Ziel der KI-Forschung. Obwohl Maschinen kein menschliches Intelligenzniveau erreicht haben und möglicherweise auch nie erreichen werden, bietet die neuromorphe Datenverarbeitung das Potenzial für Fortschritte auf dem Weg zu diesem Ziel.

Das Human Brain Project ist beispielsweise ein AGI-Projekt, das die neuromorphen Supercomputer SpiNNaker und BrainScaleS verwendet, um ausreichende neurobiologische Funktionen auszuführen und Bewusstsein zu erzeugen.

Einige der Kriterien zur Bestimmung, ob eine Maschine künstliche allgemeine Intelligenz erreicht hat, sind, ob die Maschine über die folgenden Fähigkeiten verfügt:

- unter Unsicherheit urteilen und Entscheidungen treffen

- planen

- lernen

- Verständnis für natürliche Sprache zeigen

- Wissen äußern, einschließlich Alltagswissen

- Fähigkeiten in die Verfolgung eines gemeinsamen Ziels integrieren

Manchmal werden auch die Fähigkeit zur Vorstellungskraft, subjektive Erfahrung und Selbstwahrnehmung einbezogen. Zu den weiteren vorgeschlagenen Methoden zur Bestätigung von AGI gehört der Turing-Test, der besagt, dass eine Maschine empfindungsfähig ist, wenn ein Beobachter sie nicht von einem Menschen unterscheiden kann. Der Robot College Student Test ist ein weiterer Test, bei dem sich eine Maschine für Kurse einschreibt und wie ein menschlicher Student einen Abschluss erwirbt.

Es gibt Debatten über ethische und rechtliche Fragen im Zusammenhang mit dem Umgang mit einer empfindungsfähigen Maschine. Einige argumentieren, dass empfindungsfähige Maschinen in den Augen des Gesetzes als nichtmenschliche Tiere behandelt werden sollten. Andere argumentieren, dass eine empfindungsfähige Maschine wie eine Person behandelt und durch dieselben Gesetze wie Menschen geschützt werden sollte. Viele KI-Entwickler befolgen einen KI-Ethikkodex, der Leitprinzipien für die Entwicklung von KI vorgibt.

Geschichte des neuromorphen Computings

Seit Jahrzehnten versuchen Wissenschaftler, Maschinen zu entwickeln, die menschliche Kognition ermöglichen. Die Arbeit in diesem Bereich ist eng mit den Fortschritten in der Mathematik und den Neurowissenschaften verbunden. Zu den ersten Durchbrüchen gehören:

1936. Der Mathematiker und Informatiker Alan Turing erstellte einen mathematischen Beweis dafür, dass ein Computer jede mathematische Berechnung durchführen kann, wenn sie in Form eines Algorithmus bereitgestellt wird.

1948. Turing schrieb Intelligent Machinery, ein Dokument, in dem eine kognitive Modellierungsmaschine auf der Grundlage menschlicher Neuronen beschrieben wurde.

1949. Der kanadische Psychologe Donald Hebb erzielte einen Durchbruch in den Neurowissenschaften, indem er eine Korrelation zwischen synaptischer Plastizität und Lernen theoretisierte. Hebb wird allgemein als Vater der Neuropsychologie bezeichnet.

1950. Turing entwickelte den Turing-Test, der immer noch als Standardtest für künstliche allgemeine Intelligenz gilt.

1958. Aufbauend auf diesen Theorien entwickelte die US-Marine das Perzeptron mit der Absicht, es für die Bilderkennung einzusetzen. Die Nachahmung biologischer neuronaler Netze durch die Technologie basierte jedoch auf begrenztem Wissen über die Funktionsweise des Gehirns und konnte die beabsichtigte Funktionalität nicht erfüllen. Dennoch gilt das Perzeptron als Vorläufer des neuromorphen Computings.

1980er Jahre. Das neuromorphe Computing, wie wir es heute kennen, wurde erstmals von Caltech-Professor Carver Mead vorgeschlagen. Mead schuf 1981 die erste analoge Silizium-Retina und -Cochlea, die eine neue Art der physikalischen Berechnung vorwegnahm, die vom neuronalen Paradigma inspiriert war. Mead schlug vor, dass Computer alles tun können, was das menschliche Nervensystem tut, wenn man die Funktionsweise des Nervensystems vollständig verstehen würde.

2013. Henry Markram startete das HBP mit dem Ziel, ein künstliches menschliches Gehirn zu schaffen. Das HBP umfasst neuromorphe Computer auf dem neuesten Stand der Technik, um das menschliche Gehirn besser zu verstehen und dieses Wissen in Medizin und Technologie anzuwenden. Über 500 Wissenschaftler und 140 Universitäten in ganz Europa arbeiten an dem Projekt.

2014. IBM entwickelte den neuromorphen Chip TrueNorth. Der Chip wird in der visuellen Objekterkennung eingesetzt und hat einen geringeren Stromverbrauch als herkömmliche von-Neumann-Hardware.

2018. Intel entwickelte den neuromorphen Chip Loihi, der in der Robotik sowie in der Gesten- und Geruchserkennung eingesetzt wurde.

Die Zukunft des neuromorphen Computings

Die jüngsten Fortschritte in der neuromorphen Forschung sind zum Teil auf den weit verbreiteten und zunehmenden Einsatz von KI, maschinellem Lernen, neuronalen Netzen und tiefen neuronalen Netzwerkarchitekturen in der Consumer- und Unternehmenstechnologie zurückzuführen. Sie sind auch auf das von vielen IT-Experten wahrgenommene Ende des Mooreschen Gesetzes zurückzuführen.

Das Mooresche Gesetz besagt, dass sich die Anzahl der Transistoren, die auf einem Mikrochip platziert werden können, alle zwei Jahre verdoppelt, wobei die Kosten gleich bleiben. Experten prognostizieren jedoch, dass das Ende des Mooreschen Gesetzes unmittelbar bevorsteht. Angesichts dessen hat das Versprechen des neuromorphen Rechnens, traditionelle Architekturen zu umgehen und neue Effizienzniveaus zu erreichen, die Aufmerksamkeit der Chiphersteller auf sich gezogen.

Jüngste Entwicklungen bei neuromorphen Rechensystemen haben sich auf neue Hardware konzentriert, wie zum Beispiel Microcombs. Microcombs sind neuromorphe Geräte, die äußerst präzise Farbfrequenzen erzeugen oder messen. Laut einer neuromorphen Forschungsarbeit an der Swinburne University of Technology können neuromorphe Prozessoren, die Microcombs verwenden, zehn Billionen Operationen pro Sekunde ausführen. Neuromorphe Prozessoren, die Microcombs verwenden, können das Licht entfernter Planeten erkennen und möglicherweise Krankheiten in frühen Stadien diagnostizieren, indem sie den Inhalt der ausgeatmeten Luft analysieren.

Aufgrund des Versprechens, die Effizienz durch neuromorphes Computing zu verbessern, hat es die Aufmerksamkeit großer Chiphersteller wie IBM und Intel sowie des US-Militärs auf sich gezogen. Entwicklungen in der neuromorphen Technologie könnten die Lernfähigkeit modernster autonomer Geräte wie fahrerloser Autos und Drohnen verbessern.