¿Qué es la ética para la IA?

La ética en inteligencia artificial (IA) es un sistema de principios y técnicas morales destinados a orientar el desarrollo y el uso responsable de la tecnología de inteligencia artificial. A medida que la IA se ha convertido en parte integral de los productos y servicios, las organizaciones también están comenzando a desarrollar códigos de ética para IA.

Un código de ética de IA, también llamado plataforma de valor de la IA, es una declaración de política que define formalmente el papel de la inteligencia artificial en lo que respecta al desarrollo y el bienestar de los seres humanos. El objetivo de un código de ética de IA es proporcionar orientación a las partes interesadas cuando se enfrentan a una decisión ética con respecto al uso de la inteligencia artificial.

Isaac Asimov, un escritor de ciencia ficción, previó los peligros potenciales de los agentes autónomos de IA en 1942, mucho antes del desarrollo de los sistemas de IA. Creó las Tres Leyes de la Robótica como un medio para limitar esos riesgos. En el código de ética de Asimov, la primera ley prohíbe a los robots dañar activamente a los humanos o permitir que se les haga daño negándose a actuar. La segunda ley ordena a los robots obedecer a los humanos a menos que las órdenes no estén de acuerdo con la primera ley. La tercera ley ordena a los robots protegerse a sí mismos en la medida en que hacerlo esté de acuerdo con las dos primeras leyes.

En la actualidad, los posibles peligros de los sistemas de IA incluyen la sustitución de puestos de trabajo por parte de la IA, las alucinaciones de la IA, las falsificaciones profundas y el sesgo de la IA. Estos problemas podrían ser responsables de despidos de personas, información engañosa, imitaciones falsas de imágenes o voces de otros o decisiones prejuiciosas que podrían afectar negativamente a las vidas humanas.

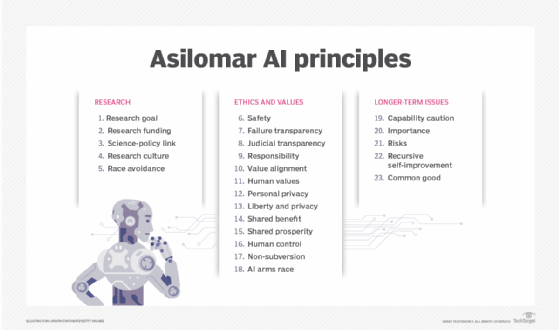

El rápido avance de la IA en los últimos 10 años ha impulsado a grupos de expertos a desarrollar salvaguardas para proteger a los humanos de los riesgos que supone la IA. Uno de esos grupos es el Future of Life Institute, una organización sin fines de lucro fundada por el cosmólogo del Instituto Tecnológico de Massachusetts, Max Tegmark, el cofundador de Skype, Jaan Tallinn, y la científica investigadora de DeepMind en Google, Victoria Krakovna. El instituto trabajó con investigadores y desarrolladores de IA, así como con académicos de muchas disciplinas, para crear las 23 directrices que ahora se conocen como Principios de IA de Asilomar.

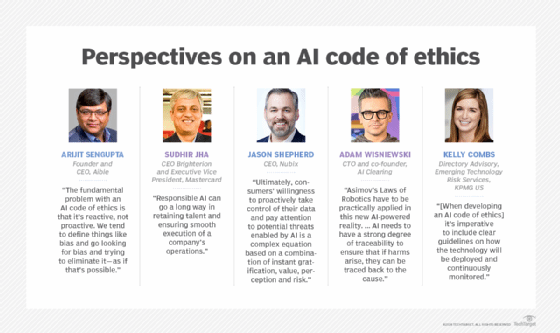

Kelly Combs, directora de asesoramiento de servicios de riesgo de tecnología emergente de KPMG, dijo que, al desarrollar un código de ética de IA, "es imperativo incluir pautas claras sobre cómo se implementará la tecnología y se monitoreará continuamente". Estas políticas deberían exigir medidas que eviten sesgos involuntarios en los algoritmos de aprendizaje automático (ML) , detecten continuamente desviaciones en los datos y algoritmos y realicen un seguimiento tanto de la procedencia de los datos como de la identidad de quienes entrenan los algoritmos.

Principios de la ética de IA

No existe un conjunto de principios definidos de ética de IA que se puedan seguir al implementar un sistema de IA. Algunos principios, por ejemplo, siguen el ejemplo del Informe Belmont, un documento de 1979 creado por la Comisión Nacional para la Protección de los Sujetos Humanos de la Investigación Biomédica y Conductual de Estados Unidos. En él se hacía referencia a los tres principios rectores siguientes para el tratamiento ético de los sujetos humanos:

- Respeto a las personas. Reconoce la autonomía de los individuos y se relaciona con la idea del consentimiento informado.

- Beneficencia. Se relaciona con la idea de no hacer daño.

- Justicia. Este principio se centra en la equidad y la igualdad.

Aunque el Informe Belmont se desarrolló originalmente con relación a la investigación en seres humanos, recientemente lo han aplicado investigadores académicos e institutos de políticas al desarrollo de la IA. El primer punto se relaciona con el consentimiento y la transparencia en relación con los derechos individuales al interactuar con sistemas de IA. El segundo punto se relaciona con garantizar que los sistemas de IA no causen daños, como por ejemplo amplificar sesgos. Y el tercer punto se relaciona con la forma en que se distribuye equitativamente el acceso a la IA.

Otras ideas comunes cuando se trata de los principios éticos de la IA incluyen las siguientes:

- Transparencia y rendición de cuentas.

- Desarrollo y uso centrado en el ser humano.

- Seguridad.

- Sostenibilidad e impacto.

¿Por qué es importante la ética en la IA?

La IA es una tecnología diseñada por humanos para replicar, aumentar o reemplazar la inteligencia humana. Estas herramientas suelen depender de grandes volúmenes de diversos tipos de datos para desarrollar conocimientos. Los proyectos mal diseñados que se basan en datos defectuosos, inadecuados o sesgados pueden tener consecuencias no deseadas y potencialmente dañinas. Además, el rápido avance de los sistemas algorítmicos significa que, en algunos casos, no está claro cómo la IA llegó a sus conclusiones, por lo que los humanos dependen esencialmente de sistemas que no pueden explicar para tomar decisiones que podrían afectar a la sociedad.

Un marco ético de la IA es importante porque destaca los riesgos y beneficios de las herramientas de IA y establece pautas para su uso responsable. Para elaborar un sistema de principios morales y técnicas para utilizar la IA de manera responsable, la industria y las partes interesadas deben examinar cuestiones sociales importantes y, en última instancia, la cuestión de qué nos hace humanos.

¿Cuáles son los desafíos éticos de la IA?

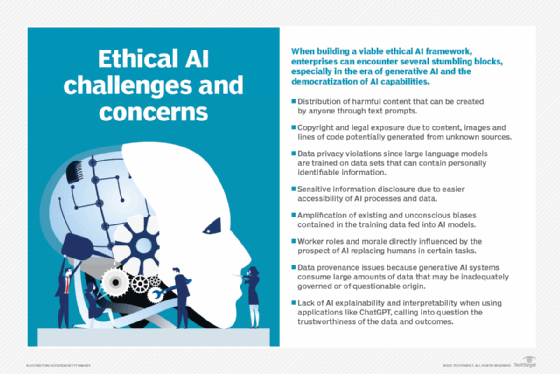

Las empresas enfrentan los siguientes desafíos éticos en el uso de tecnologías de IA:

- Explicabilidad. Cuando los sistemas de IA fallan, los equipos deben poder rastrear una compleja cadena de sistemas algorítmicos y procesos de datos para averiguar por qué. Las organizaciones que utilizan IA deben poder explicar los datos de origen, los datos resultantes, lo que hacen sus algoritmos y por qué lo hacen. "La IA debe tener un alto grado de trazabilidad para garantizar que, si surgen daños, se pueda rastrear su causa", dijo Adam Wisniewski, director de tecnología y cofundador de AI Clearing.

- Responsabilidad. La sociedad aún está decidiendo quiénes son los responsables cuando las decisiones tomadas por sistemas de IA tienen consecuencias catastróficas, como la pérdida de capital, salud o vidas. El proceso de abordar la rendición de cuentas por las consecuencias de las decisiones basadas en IA debería involucrar a una variedad de partes interesadas, incluidos abogados, reguladores, desarrolladores de IA, organismos de ética y ciudadanos. Un desafío es encontrar el equilibrio adecuado en los casos en que un sistema de IA puede ser más seguro que la actividad humana que está duplicando pero aún causa problemas, como sopesar los méritos de los sistemas de conducción autónoma que causan muertes, pero mucho menos que las personas.

- Imparcialidad. En los conjuntos de datos que contienen información personal identificable, es sumamente importante garantizar que no haya sesgos en términos de raza, género o etnia.

- Ética. Los algoritmos de IA pueden utilizarse con fines distintos a aquellos para los que fueron creados. Por ejemplo, las personas podrían utilizar la tecnología para hacer deepfakes de otras personas o para manipularlas difundiendo información errónea. Wisniewski dijo que estos escenarios deberían analizarse en la etapa de diseño para minimizar los riesgos e introducir medidas de seguridad para reducir los efectos adversos en tales casos.

- Privacidad. Debido a que la IA requiere cantidades masivas de datos para entrenarse adecuadamente, algunas empresas están utilizando datos públicos, como datos de foros web o publicaciones en redes sociales, para el entrenamiento. Otras empresas como Facebook, Google y Adobe también han incluido en sus políticas la posibilidad de utilizar datos de los usuarios para entrenar sus modelos de IA, lo que ha provocado controversias en cuanto a la protección de los datos de los usuarios.

- Desplazamiento de puestos de trabajo. En lugar de utilizar la IA para facilitar el trabajo de los humanos, algunas organizaciones podrían optar por utilizar herramientas de IA para sustituir por completo los puestos de trabajo de los humanos. Esta práctica ha suscitado controversia, ya que afecta directamente a quienes sustituye y los sistemas de IA siguen siendo propensos a las alucinaciones y otras imperfecciones.

- Medioambiental. Los modelos de IA requieren mucha energía para entrenarse y funcionar, lo que deja una gran huella de carbono. Si la electricidad que utilizan se genera principalmente a partir de carbón o combustibles fósiles, causan aún más contaminación.

El lanzamiento público y la rápida adopción de aplicaciones de IA generativa, como ChatGPT y Dall-E, que se entrenan con datos existentes para generar contenido nuevo, amplifican los problemas éticos relacionados con la IA, introduciendo riesgos relacionados con la desinformación, el plagio, la violación de derechos de autor y el contenido dañino.

¿Cuáles son los beneficios de la IA ética?

La rápida aceleración en la adopción de IA en las empresas ha coincidido con –y, en muchos casos, ha ayudado a impulsar– dos tendencias importantes: el aumento de la orientación al cliente y el aumento del activismo social.

"Las empresas son recompensadas no sólo por ofrecer productos y servicios personalizados, sino también por defender los valores del cliente y hacer el bien a la sociedad en la que operan", afirmó Sudhir Jha, director ejecutivo de Brighterion y vicepresidente ejecutivo de Mastercard.

La IA desempeña un papel muy importante en la forma en que los consumidores interactúan con una marca y la perciben. Es necesario un uso responsable para garantizar un impacto positivo. Además de los consumidores, los empleados quieren sentirse bien con las empresas para las que trabajan. " La IA responsable puede contribuir en gran medida a retener el talento y garantizar la ejecución fluida de las operaciones de una empresa", afirmó Jha.

¿Qué es un código de ética para IA?

Un enfoque proactivo para garantizar una IA ética requiere abordar las siguientes tres áreas clave, según Jason Shepherd, director ejecutivo de Atym:

- Políticas. Esto incluye el desarrollo del marco adecuado para impulsar la estandarización y establecer regulaciones. Documentos como los Principios de IA de Asilomar pueden ser útiles para iniciar la conversación. Las agencias gubernamentales en los Estados Unidos, Europa y otros lugares han lanzado esfuerzos para garantizar una IA ética, y hay una serie de estándares, herramientas y técnicas de organismos de investigación, proveedores e instituciones académicas disponibles para ayudar a las organizaciones a diseñar políticas de IA. Consulte la sección "Recursos para desarrollar una IA ética" a continuación. Las políticas de IA ética deben abordar cómo abordar las cuestiones legales cuando algo sale mal. Las empresas deben considerar la incorporación de políticas de IA en sus propios códigos de conducta. Pero la eficacia depende de que los empleados cumplan las reglas, lo que puede no ser siempre realista cuando están en juego el dinero o el prestigio.

- Educación. Los ejecutivos, los científicos de datos, los empleados de primera línea y los consumidores deben comprender las políticas, las consideraciones clave y los posibles efectos negativos de la IA poco ética y los datos falsos. Una gran preocupación es la disyuntiva entre la facilidad de uso en torno al intercambio de datos y la automatización de la IA y las posibles repercusiones negativas del exceso de intercambio o la automatización adversa. "En última instancia, la voluntad de los consumidores de tomar el control de sus datos de forma proactiva y prestar atención a las posibles amenazas que permite la IA es una ecuación compleja basada en una combinación de gratificación instantánea, valor, percepción y riesgo", dijo Shepherd.

- Tecnología. Los ejecutivos también necesitan diseñar sistemas de IA para detectar automáticamente datos falsos y comportamientos poco éticos. Esto requiere no solo observar la propia IA de una empresa, sino también investigar a los proveedores y socios para detectar el uso malicioso de la IA. Los ejemplos incluyen el despliegue de videos y textos falsos para debilitar a un competidor, o el uso de IA para lanzar ciberataques sofisticados. Esto se convertirá en un problema más grave a medida que las herramientas de IA se conviertan en productos básicos. Para combatir este posible efecto de bola de nieve, las organizaciones deben invertir en medidas defensivas arraigadas en una infraestructura de IA abierta, transparente y confiable. Shepherd cree que esto dará lugar a la adopción de la confianza que proporciona un enfoque a nivel de sistema para automatizar la garantía de la privacidad, garantizar la confianza de los datos y detectar el uso poco ético de la IA.

Ejemplos de códigos éticos de IA

Un código de ética de la IA puede explicar los principios y proporcionar la motivación que impulsa el comportamiento adecuado. Por ejemplo, a continuación se resume el código de ética de la IA de Mastercard:

- Un sistema de IA ético debe ser inclusivo, explicable, de naturaleza positiva y utilizar los datos de manera responsable.

- Un sistema de IA inclusivo es imparcial. Los modelos de IA requieren entrenamiento con conjuntos de datos grandes y diversos para ayudar a mitigar el sesgo. También requiere atención y ajustes constantes para cambiar cualquier atributo problemático aprendido en el proceso de entrenamiento.

- Un sistema de IA explicable debe ser manejable para garantizar que las empresas puedan implementarlo de manera ética. Los sistemas deben ser transparentes y explicables.

- Un sistema de IA debe tener y mantener un propósito positivo. En muchos casos, esto podría hacerse para ayudar a los humanos en su trabajo, por ejemplo. Los sistemas de IA deben implementarse de manera que no puedan usarse con fines negativos.

- Los sistemas de IA éticos también deben respetar los derechos de privacidad de los datos. Si bien los sistemas de IA suelen requerir una enorme cantidad de datos para entrenarse, las empresas no deberían sacrificar los derechos de privacidad de los datos de sus usuarios u otras personas para lograrlo.

Empresas como Mastercard, Salesforce y Lenovo se han comprometido a firmar un código de conducta voluntario en materia de IA, lo que significa que están comprometidas con el desarrollo y la gestión responsables de los sistemas de IA generativa. El código se basa en el desarrollo de un código de ética canadiense sobre IA generativa, así como en las aportaciones recogidas de un conjunto de partes interesadas.

Google también tiene sus propios principios rectores de IA, que enfatizan la responsabilidad de la IA, los beneficios potenciales, la equidad, la privacidad, la seguridad y los valores sociales y otros valores humanos.

Recursos para desarrollar una IA ética

A continuación se presenta una muestra del creciente número de organizaciones, formuladores de políticas y estándares regulatorios enfocados en el desarrollo de prácticas éticas de IA:

- Instituto AI Now. El instituto se centra en las implicaciones sociales de la IA y en la investigación de políticas para una IA responsable. Las áreas de investigación incluyen la rendición de cuentas algorítmica, las cuestiones antimonopolio, la biometría, los derechos de los trabajadores sobre los datos, los modelos de IA a gran escala y la privacidad. El informe "AI Now 2023 Landscape: Confronting Tech Power" ofrece un análisis profundo de muchas cuestiones éticas que pueden resultar útiles para desarrollar políticas éticas en materia de IA.

- Centro Berkman Klein para Internet y Sociedad de la Universidad de Harvard. El centro fomenta la investigación sobre las grandes cuestiones relacionadas con la ética y la gobernanza de la IA. Las investigaciones apoyadas por el centro han abordado temas que incluyen la calidad de la información, los algoritmos en la justicia penal, el desarrollo de marcos de gobernanza de la IA y la rendición de cuentas algorítmica.

- Comité Técnico Mixto CEN-CENELEC 21 sobre Inteligencia Artificial. El JTC 21 es una iniciativa de la Unión Europea (UE) en curso para la elaboración de diversas normas de IA responsable. El grupo elabora normas para el mercado europeo y aporta información sobre la legislación, las políticas y los valores de la UE. También especifica los requisitos técnicos para caracterizar la transparencia, la solidez y la precisión de los sistemas de IA.

- Manual del Instituto de Tecnología, Ética y Cultura. El Manual del ITEC es un esfuerzo colaborativo entre el Centro Markkula de Ética Aplicada de la Universidad de Santa Clara y el Vaticano para desarrollar una hoja de ruta práctica e incremental para la ética tecnológica. El Manual del ITEC incluye un modelo de madurez de cinco etapas con pasos específicos y mensurables que las empresas pueden adoptar en cada nivel de madurez. También promueve un enfoque operativo para implementar la ética como una práctica continua, similar a DevSecOps para la ética. La idea central es reunir a los equipos legales, técnicos y comerciales durante las primeras etapas de la IA ética para erradicar los errores en un momento en que es mucho más barato solucionarlos que después de una implementación de IA responsable.

- Orientación de TI e IA sobre Gestión de Riesgos ISO/IEC 23894:2023. La Organización Internacional de Normalización y la Comisión Electrotécnica Internacional describen cómo una organización puede gestionar los riesgos específicamente relacionados con la IA. La guía puede ayudar a estandarizar el lenguaje técnico que caracteriza los principios subyacentes y cómo se aplican al desarrollo, suministro u oferta de sistemas de IA. También cubre políticas, procedimientos y prácticas para evaluar, tratar, monitorear, revisar y registrar el riesgo. Es altamente técnica y está orientada a ingenieros en lugar de expertos en negocios.

- Marco de gestión de riesgos de IA del NIST. Esta guía del Instituto Nacional de Normas y Tecnología para agencias gubernamentales y el sector privado se centra en la gestión de nuevos riesgos de IA y la promoción de una IA responsable. Abhishek Gupta, fundador e investigador principal del Instituto de Ética de IA de Montreal, destacó la profundidad del marco del NIST, especialmente su especificidad en la implementación de controles y políticas para gobernar mejor los sistemas de IA en diferentes contextos organizacionales.

- Nvidia NeMo Guardrails. Este kit de herramientas proporciona una interfaz flexible para definir pautas de comportamiento específicas que los bots deben seguir. Es compatible con el lenguaje de modelado Colang. Un científico de datos jefe dijo que su empresa utiliza el kit de herramientas de código abierto para evitar que un chatbot de soporte en el sitio web de un abogado proporcione respuestas que puedan interpretarse como asesoramiento legal.

- Instituto de Stanford para la Inteligencia Artificial Centrada en el Ser Humano. La misión del Instituto es proporcionar investigación y orientación continuas sobre las mejores prácticas para la IA centrada en el ser humano. Una de las primeras iniciativas en colaboración con Stanford Medicine es "IA responsable para una salud segura y equitativa", que aborda cuestiones éticas y de seguridad relacionadas con la IA en la salud y la medicina.

- "Hacia Objetivos Unificados para una IA Autorreflexiva". Este artículo, escrito por Matthias Samwald, Robert Praas y Konstantin Hebenstreit, adopta un enfoque socrático para identificar suposiciones, contradicciones y errores subyacentes a través del diálogo y el cuestionamiento sobre la veracidad, la transparencia, la solidez y la alineación de los principios éticos. Uno de los objetivos es desarrollar metasistemas de IA en los que dos o más modelos de IA componentes se complementen, critiquen y mejoren su desempeño mutuo.

- "Recomendaciones de El Presidio sobre la IA generativa responsable" del Foro Económico Mundial. Estas 30 recomendaciones orientadas a la acción ayudan a abordar las complejidades de la IA y a aprovechar su potencial de manera ética. Este documento técnico también incluye secciones sobre el desarrollo y la publicación responsables de la IA generativa, la innovación abierta, la colaboración internacional y el progreso social.

Estas organizaciones ofrecen una variedad de recursos que sirven como una base sólida para desarrollar prácticas éticas de IA. Usarlos como marco puede ayudar a orientar a las organizaciones para garantizar que desarrollen y utilicen la IA de manera ética.

El futuro de la IA ética

Algunos sostienen que un código de ética de la IA puede quedar obsoleto rápidamente y que se necesita un enfoque más proactivo para adaptarse a un campo que evoluciona rápidamente. Arijit Sengupta, fundador y director ejecutivo de Aible, una plataforma de desarrollo de IA, dijo: "El problema fundamental con un código de ética de la IA es que es reactivo, no proactivo. Tendemos a definir cosas como sesgo y a buscar sesgos para tratar de eliminarlos, como si eso fuera posible".

Un enfoque reactivo puede tener problemas para lidiar con el sesgo incorporado en los datos. Por ejemplo, si las mujeres no han recibido préstamos a la tasa adecuada a lo largo del tiempo, eso se refleja en los datos de múltiples maneras. "Si eliminas las variables relacionadas con el género, la IA simplemente detectará otras variables que sirvan como indicador del género", dijo Sengupta.

Sengupta cree que el futuro de la IA ética debe hablar de definir la equidad y las normas sociales. Por ejemplo, en un banco que otorga préstamos, los equipos de administración e IA tendrían que decidir si quieren apuntar a una consideración igualitaria, como préstamos procesados a una tasa igual para todas las razas; resultados proporcionales, donde la tasa de éxito para cada raza es relativamente igual; o impacto igualitario, lo que garantiza que una cantidad proporcional de préstamos se destine a cada raza. El enfoque debe estar en un principio rector en lugar de en algo que se debe evitar, argumentó Sengupta.

La mayoría de la gente está de acuerdo en que es más fácil y eficaz enseñar a los niños cuáles deben ser sus principios rectores en lugar de enumerar todas las decisiones posibles a las que se pueden enfrentar y decirles qué hacer y qué no hacer. "Ese es el enfoque que estamos adoptando con la ética de la IA", dijo Sengupta. "Le estamos diciendo a un niño todo lo que puede y no puede hacer, en lugar de proporcionarle principios rectores y luego permitirle que lo averigüe por sí mismo".

Por ahora, los humanos desarrollan reglas y tecnologías que promueven una IA responsable. Shepherd dijo que esto incluye la programación de productos y ofertas que protejan los intereses humanos y no estén sesgados contra ciertos grupos, como las minorías, las personas con necesidades especiales y los pobres. Esto último es especialmente preocupante, ya que la IA tiene el potencial de estimular una guerra social y económica masiva, profundizando la brecha entre aquellos que pueden permitirse la tecnología, incluida la mejora humana, y aquellos que no pueden.

La sociedad también necesita urgentemente prepararse para el uso poco ético de la IA por parte de actores maliciosos. Los sistemas de IA actuales varían desde sofisticados motores de reglas hasta modelos de aprendizaje automático que automatizan tareas simples y sistemas de IA generativos que imitan la inteligencia humana. "Puede que pasen décadas antes de que empiecen a surgir IA más sensibles que puedan automatizar su propio comportamiento poco ético a una escala que los humanos no podrían seguir", dijo Shepherd. Pero, dada la rápida evolución de la IA, ahora es el momento de desarrollar las barandillas para prevenir este escenario.

En el futuro, es posible que aumenten las demandas judiciales, como la que presentó The New York Times contra OpenAI y Microsoft con relación al uso de artículos del Times como datos de entrenamiento de la IA. OpenAI también se ha visto envuelta en más controversias que podrían influir en el futuro, como su consideración de avanzar hacia un modelo de negocio con fines de lucro. Elon Musk también ha anunciado un modelo de IA que generó controversia tanto por las imágenes que puede crear como por el impacto ambiental y social del lugar físico en el que se coloca. El futuro de la IA podría seguir viendo esta superación de los límites éticos por parte de las empresas de IA, así como un rechazo a las preocupaciones éticas, sociales y económicas y un llamado a implementaciones más éticas por parte de los gobiernos y los ciudadanos.