olly - Fotolia

Big data arroja grandes sesgos en los conjuntos de datos del aprendizaje automático

La IA tiene un gran potencial para el bien, pero también amplifica los resultados negativos si los científicos de datos no reconocen los sesgos en los datos y los corrigen en los conjuntos de datos de aprendizaje automático.

Supongamos que está entrenando un sistema de reconocimiento de imágenes para identificar a los presidentes de EE.UU. Los datos históricos revelan un patrón de hombres, por lo que el algoritmo concluye que solo los hombres son presidentes. No reconocerá a una mujer en ese rol, a pesar de que es un resultado probable en futuras elecciones.

Este sesgo latente es uno de los muchos tipos de sesgos que desafían hoy a los científicos de datos. Si el conjunto de datos del aprendizaje automático que usan en un proyecto de inteligencia artificial no es neutral, y es seguro decir que casi ningún dato lo es, los resultados en realidad pueden amplificar el sesgo y la discriminación presentes en el conjunto de datos de aprendizaje automático.

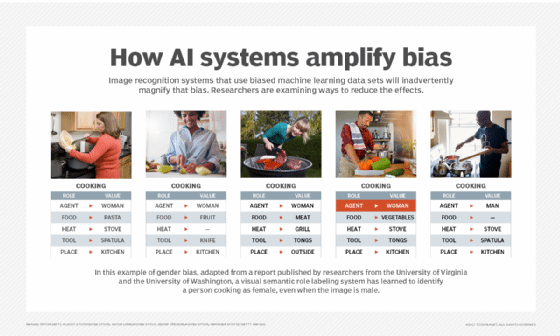

Las tecnologías de reconocimiento visual que etiquetan imágenes requieren grandes cantidades de datos etiquetados, que provienen en gran parte de la web. Puede imaginarse los peligros en eso, y los investigadores de la Universidad de Washington y la Universidad de Virginia confirmaron un conmovedor ejemplo de sesgo de género en un informe reciente.

Descubrieron que, cuando un sistema visual de etiquetado de roles semánticos ve una espátula, etiqueta el utensilio como una herramienta de cocina, pero también es probable que se refiera a la persona en la cocina que sostiene esa herramienta como mujer, incluso cuando la imagen de datos de entrenamiento es un hombre. Sin cuantificar y reducir adecuadamente este tipo de correlación, las herramientas de aprendizaje automático ampliarán los estereotipos, concluyeron los investigadores.

Por lo tanto, si bien los proyectos de inteligencia artificial ofrecen enormes beneficios, las empresas que evalúan las iniciativas de IA también deben comprender los peligros asociados con la creación de sistemas que ofrecen resultados sesgados. En su informe de noviembre de 2017, "Predicciones 2018: Inteligencia Artificial", Gartner advirtió que el sesgo de datos puede tener impactos devastadores y altamente públicos en los resultados de IA. Advirtieron a los ejecutivos que garanticen la rendición de cuentas y la transparencia en sus metodologías.

Corregir el sesgo en los datos

Los proveedores de inteligencia artificial, incluidos Google, IBM y Microsoft, dicen que están trabajando para resolver el problema del sesgo de datos, en la medida en que pueda ser resuelto, de modo que sus sistemas de IA como servicio sean confiables para los usuarios de todo el mundo. Eso no es un logro pequeño, porque lo que parece imparcial para un programador en China o India puede ser visto como un sesgo negativo para un programador en los EE.UU. Cuando un programador intenta "corregir" manualmente un prejuicio o prejuicio, se introduce el sesgo cognitivo de ese programador y afecta los resultados.

Anthony Scriffignano

Anthony Scriffignano

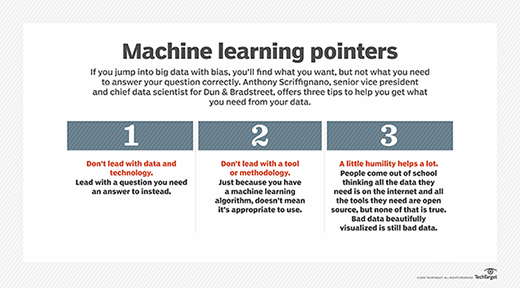

"Casi todos los datos tienen prejuicios, y si intenta eliminarlos, introduce otro tipo de sesgo", explicó Anthony Scriffignano, vicepresidente senior y científico jefe de datos de Dun & Bradstreet, que proporciona datos comerciales, análisis e información a empresas de todo el mundo. "A menudo no se puede eliminar, por lo que es importante comprenderlo y el impacto que tiene en la decisión que está tomando". Además, es importante articular claramente cuál es el sesgo en los datos, un paso que muchos científicos de datos omiten, porque la gente trabaja desde la suposición de que sus datos son completamente ciertos y apropiados para el análisis, dijo Scriffignano.

Pero detectar un sesgo puede ser complicado, especialmente cuando el algoritmo está oculto, como en el caso de las cajas negras, y donde los sesgos se introdujeron en algún punto del camino. Y ciertamente hay escenarios en los que el sesgo de datos se ignora u oculta, lo que lleva a su perpetuación.

Como la matemática y científica de datos, Cathy O'Neil, dijo en su charla Ted2017: "Los algoritmos son opiniones, integradas en el código". En esa charla, ella destacó el problema de los tecnólogos que blanquean datos al ocultar "verdades desagradables" en algoritmos de caja negra. Ese tipo de datos se usa para construir algoritmos "secretos, importantes y destructivos" como un medio de riqueza y poder, algoritmos que ella llama "armas de destrucción matemática".

Jeff Adams, CEO de Cobalt Speech & Language, una empresa de tecnología del lenguaje que ayuda a las empresas a construir productos que incorporan interfaces de lenguaje natural, conoce muy bien los problemas de sesgo de datos. "Nos topamos con el problema del sesgo de datos cada semana, es el problema que está en el centro de atención", dijo.

La creación de una interfaz conversacional requiere datos que representen todos los dialectos, giros culturales de frases y la jerga que las personas usan durante el curso de una conversación, más el análisis del tono e intención de la persona que, en el caso del sarcasmo, es lo contrario de lo que persona realmente quiere decir.

Tomemos el ejemplo de los chatbots de IA diseñados para escanear sistemas de correo electrónico y establecer citas automáticamente. Si bien es útil en teoría, este tipo de automatización puede ser un problema si la conversación no se interpreta correctamente. "Estoy aterrorizado por la idea de que un sistema establezca automáticamente una reunión con alguien, basado en una conversación por correo electrónico, porque podría estar diciendo 'Sí, vamos a conocerlo', pero realmente estoy pensando 'diablos, no'", dijo Scriffignano durante su presentación en el AI World de diciembre en Boston.

Lo que falta en los conjuntos de datos de aprendizaje automático crea sesgo

Más allá de comprender la intención de la persona que habla, los científicos de datos deben asegurarse de que haya datos adecuados de ambos sexos para que las herramientas de reconocimiento de voz funcionen igual de bien para hombres y mujeres. Otros factores también juegan un papel. Tiende a haber más energía en el procesamiento de la señal de una voz masculina, lo que puede ayudar a la precisión, mientras que las mujeres, cultural o biológicamente, podrían hablar más claramente que los hombres, lo que podría hacer oscilar el péndulo, dijo Adams.

De hecho, la búsqueda y el entrenamiento de algoritmos utilizando conjuntos de datos reales y representativos de aprendizaje automático es el componente más difícil del procesamiento del lenguaje natural y de otras aplicaciones relacionadas con la IA. Es importante que los científicos de datos reconozcan las lagunas de datos para evitar conclusiones basadas en datos incompletos.

En un momento en que los ejecutivos dependen en gran medida de los datos para tomar decisiones, no tener los datos necesarios para desarrollar el análisis puede ser paralizante. Cuando sucedió Brexit, por ejemplo, varios clientes de Dun & Bradstreet pidieron una opinión macroeconómica de ello, pero simplemente no había datos históricos para construir un análisis; era mucho más matizado, dijo Scriffignano.

"Estamos hablando de algo históricamente sin precedentes", explicó. "Podríamos haber tomado nuestros datos y arrojarlos a un algoritmo de aprendizaje automático, pero había peligro al hacer eso. Tuvimos que resistir a todas las personas que dijeron: '¿Por qué no solo'?... Podría haber sido negligencia".

En otro ejemplo, Adams recordó la construcción de una aplicación de dictado médico usando los datos en decenas de miles de informes que fueron sacados de parte de un año. Su equipo construyó un modelo de aprendizaje automático y lo puso a funcionar, solo para darse cuenta de que faltaba un mes en los conjuntos de datos de aprendizaje automático.

"Desarrollamos el modelo a ciegas y pensamos que era bueno hasta que llegamos a 'febrero', y no reconoció esa palabra", dijo Adams. "Es una historia de pensar que has hecho todo bien, pero es difícil obtener una buena cobertura de lo que sea que intentes representar".

Adams trabajó anteriormente para una compañía de transcripción de correo de voz a texto llamada Yap, que usaba modelos de reconocimiento de voz entrenados en un inglés cuidadosamente hablado, desarrollado en un laboratorio. "El problema es que, cuando las personas dejan un mensaje de voz para sus amigos, no hablan coloquialmente", señaló Adams. "Entonces, para las personas que hablaban dialectos no estándar de inglés, alguien muy urbano, por ejemplo, las transcripciones del correo de voz [no funcionaban]".

La gente imagina que hay una versión típica de lo que sea que intenten construir, pero cualquier cosa en particular implica detalles, dijo Adams. "Te imaginas lo que la gente que deja un mensaje podría decir: alguna afirmación genérica, como 'estoy retrasado'. Pero en realidad, todo es específico", dijo. Alguien de la farmacia puede dejar un mensaje de voz que dice que su doxiciclina está lista, y darle instrucciones para tomarla. O la llamada podría ser un contratista que explique algún trabajo adicional que deba realizarse, junto con sus opciones y el costo. "En otras palabras, no existe algo típico, por lo que es increíblemente difícil crear modelos que cubran todos los escenarios posibles", dijo.

Los buenos datos toman tiempo, y dinero

Cómo superar ese desafío es la pregunta de los 64.000 dólares. Pero una forma es recolectar los tipos correctos de datos y reconocer que las versiones iniciales de los modelos tendrán un rendimiento inferior en algunos aspectos, especialmente si confiaba en datos que no provenían del mundo real, reconoció Adams. "Siempre estarás discapacitado cuando intentes tomar datos creados artificialmente o desde un dominio que no coincida con lo que estás haciendo", dijo.

Tomarse el tiempo para asegurarse de tener datos correctos suficientes es fundamental para las aplicaciones de inteligencia artificial. Pero si ese lapso de tiempo se extiende más allá de los seis meses, los ejecutivos de la compañía que buscan un ROI rápido no estarán satisfechos, según los científicos de datos de AI World. Idealmente, los ejecutivos corporativos brindan a los científicos de datos el tiempo suficiente para garantizar que el producto de IA que están desarrollando funcionará bien desde el principio para todo tipo de personas. "Cuando hablamos con una compañía, tenemos que ser honestos acerca de las ventajas y desventajas, los pros y los contras. Explicamos que si lanzamos demasiado pronto, [el producto] será de calidad inferior", dijo Adams.

Yap fue adquirido por Amazon en 2011, y a través de esa adquisición, Adams se convirtió en parte del equipo que desarrolló el Amazon Echo. Dijo que Amazon no lanzaría un producto de calidad inferior y se tomó el tiempo necesario para asegurarse de que funcionaba correctamente para todo tipo de usuarios. La compañía pasó más de un año trabajando internamente en Echo; cientos de empleados de Amazon se llevaron el dispositivo a casa y lo usaron todo lo posible antes de su lanzamiento, dijo, y agregó: "Recopilamos todos los datos y no lo lanzamos hasta que estuvimos seguros de que funcionaría".